特長

GMO GPUクラウドとは

GMO GPUクラウドとは

大規模な生成AIモデルの開発には、大量のデータを最適化されたインフラ環境で処理することが求められます。

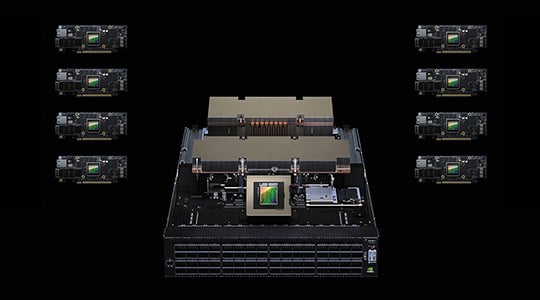

「GMO GPUクラウド」は、NVIDIA社の「NVIDIA H200 TensorコアGPU」を搭載した高性能GPUノード、国内初となるNVIDIA Spectrum -Xを採用した高速ネットワーク、

そしてDDN社の超高速ストレージを兼ね備えたシステム構成により、マルチノード構成においても圧倒的なパフォーマンスを発揮します。

2024年11月に発表されたスーパーコンピュータの性能を示す世界的ランキング「TOP500」では、国内商用クラウドとして最速の計算性能※が国際的に認められました。

生成AI開発や機械学習に最適化された国内最速レベルのGPUクラウドが、お客様の開発サイクルを飛躍的に加速させます。

※2024年11月19日時点

マルチノードでのクラスタ構成で圧倒的なパフォーマンスを発揮する国内最速レベルのGPUクラウド。

GPUクラスタの性能はGPU自体の性能だけでは決まりません。GPUの処理性能を引き出すGPU間通信帯域の広さ、ストレージの読み書き速度の速さ、そういった構成すべてが最高の選択である必要があります。

GMO GPUクラウドはマルチノードに最適なクラスタ構成にこだわり、最高の研究・学習環境をお客様にご提供します。

大規模言語モデルの開発・研究者向けにGPUメモリ容量とメモリバス帯域幅を大幅に拡大・最適化した「NVIDIA H200 Tensor コア GPU」を国内最速提供。

AIワークロード専用に設計された世界初のイーサネットファブリックであるSpectrum-Xを国内で初めて採用。 生成AIネットワークのパフォーマンスを飛躍的に向上させます。

NVIDIA製品との連携に優れたDDNの高速ストレージを採用。圧倒的な性能を持つAI開発プラットフォームをワンストップで提供。

NVIDIAが提供する一元管理されたプラットフォームで幅広いソフトウェア、管理ツール、ワークロードなどを提供。NGC Private Repositoryも利用可能。迅速に環境構築・管理を行うことができます。

クラスタシステムのための業界標準であるジョブスケジューラーです。リソースの割り当て・ジョブの制御・モニタリング機能を提供します。

| サービス |

GMO GPUクラウド NVIDIA H200 |

ConoHa VPS NVIDIA H100 |

ConoHa VPS NVIDIA L4 |

|---|---|---|---|

| 特長 | 大規模な生成AI開発や 機械学習に最適 |

モデルの学習やファイン チューニングにも対応 |

画像生成や 推論用途に最適 |

| GPU | NVIDIA H200 GPU(SXM) ×8枚 |

NVIDIA H100×1枚 | NVIDIA L4×1枚 |

| GPUメモリ | 総計1,128GB | 80GB | 24GB |

| GPUノード間通信 | 3,200Gbps | - | - |

| vCPU | 224コア | 22コア | 20コア |

| インターネット回線 | 100Gbps(共用) | 1Gbps | 1Gbps |

| データ通信料 | 無料 | 無料 | 無料 |

| 演算性能 (FP16 Tensorコア) | 15.8PFLOPS※ | 1.513PFLOPS※ | 0.242PFLOPS※ |

| OS | Ubuntu 22.04LTS | Ubuntu 22.04LTS | Ubuntu 22.04LTS |

| リージョン | 日本 | 日本 | 日本 |

※演算性能は疎性あり。

NVIDIA H200以外のGPUをご利用いただけるサービスも

ご用意しております。

お問い合わせフォームにご入力いただき、送信ボタンをクリックしてください。

弊社担当からご入力いただいたメールアドレス宛にご連絡いたします。